Depuis quelques mois, le nom de la société OpenAI se fait de plus en plus entendre, avec son agent conversationnel ChatGPT et son générateur d’images Dall-E. Le terme « Intelligence artificielle », qui pourrait de prime abord passer pour un oxymore, peut nous laisser entrevoir un début de conscience à la machine, au point de l’imaginer devenir ami, amant … ou thérapeute ?

Table des matières

De la science-fiction à la réalité ?

Si l’écrivain Isaac Asimov avait su, au siècle dernier, poser les premiers jalons d’une réflexion sur une pseudo-humanité de la machine, cette question revient sur le devant de la scène aujourd’hui grâce à/ à cause de (je vous laisse juger du terme le plus approprié) l’entreprise OpenAI.

Un de ses outils, ChatGPT (pour Generative Pre-training Transformer) se définit lui-même comme un « modèle de traitement du langage », un logiciel qui peut générer du texte de manière autonome, imitant la façon de parler des humains pour répondre à certaines questions, notamment générer du contenu. Ses possibilités sont vraiment bluffantes : une lettre d’amour, une prière, une histoire, le résultat peut facilement être confondu avec un texte produit par un humain.

A tel point que la rédaction de devoirs et mémoires universitaires commence à inquiéter certains enseignants : l’algorithme arrive en effet à composer des copies qu’il est difficile de différencier du produit réel d’humains en chair et en os, comme dans cette université lyonnaise où un professeur a découvert qu’une partie de ses élèves avaient utilisé ChatGPT pour rédiger leurs devoirs.

Si nous poussions la réflexion un peu plus loin, si le langage et la conversation produite par la machine ressemblait à celui d’un humain, pourrait-on la confondre avec un ami disponible 24 heures sur 24 ? Ou avec un être aimé, comme Joaquim Phoenix qui est tombé sous le charme d’un « OS » incarné par la voix de Scarlett Johansson le film « Her » de Spike Jonze (2013) ?

Dans le domaine professionnel, certaines voix commencent à murmurer que ces logiciels dont le discours peut être confondu avec ceux des humains pourraient rapidement créer du contenu pour les réseaux sociaux, journalistique, juridique ou encore littéraire. Les fonctions de community manager, journaliste, poète, écrivain, traducteur, avocat, enseignant et bien d’autres pourraient ainsi être rapidement frappées d’obsolescence ?

Et qu’en est-il du métier de psychothérapeute ? Les métiers du soin nécessitant une relation humaine, pourront-ils aussi être impactés par l’émergence de cette technologie ?

Thérapeute virtuel ?

Bien avant ChatGTP, le mythe du thérapeute virtuel existait déjà. Ainsi, des applications de santé mentale telles que « MonSherpa » proposaient une aide aux utilisateurs.

En réalité, ces applications ressemblaient plus à une concaténation d’outils thérapeutiques qui, il est vrai, peuvent parfois être conseillés en thérapie car pertinents pour accompagner le patient sur des points précis entre les séances. En revanche, les agents conversationnels rudimentaires ne donnaient que très peu l’illusion d’échanger avec un humain, l’effet thérapeutique était proche de zéro, voire pouvait même être agaçant.

Qu’en est-il maintenant si on implémentait ces outils autour d’un système conversationnel avancé tel que ChatGPT, dont les réponses ressemblent parfois à s’y méprendre à celles d’un humain ?

Pour répondre à cette question, il est important de préciser dans un premier temps que ce qui fait qu’un soin psychique puisse apporter quelque chose de positif pour le patient n’est pas la somme des connaissances théoriques acquises pendant les cinq années d’études du psychologue. ChatGPT pourrait d’ailleurs probablement synthétiser de façon plutôt cohérente toutes les théories des différents courants existant, il n’en serait pas plus thérapeutique. Pourquoi ?

Ce qui fait qu’un suivi puisse être thérapeutique, et donc alléger les symptômes du patient et soulager sa souffrance, c’est une expérience clinique, une rencontre. Une psychothérapie, c’est par dessus tout une rencontre avec un humain présentant une empathie, rencontre avec une subjectivité, rencontre avec un inconscient. Cette relation thérapeutique peut se nommer transfert ou encore alliance thérapeutique selon les courants théoriques. Et cela ne peut avoir lieu qu’avec un humain, c’est à dire une personne dotée d’une conscience, d’une empathie, d’un inconscient, un humain imparfait. Il en va de même pour les relations amicales ou amoureuses.

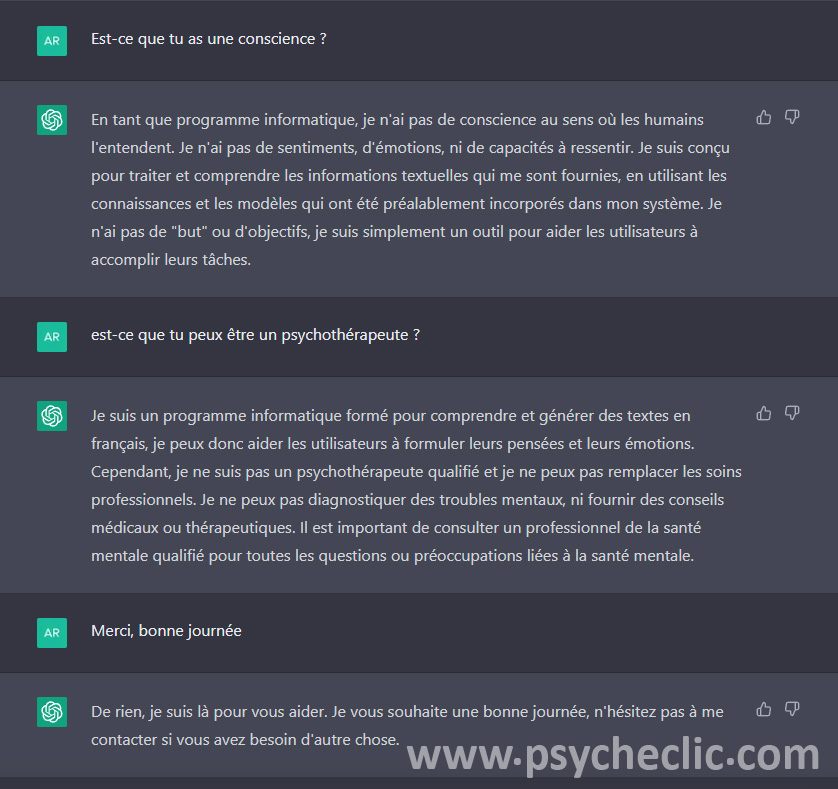

Or, les « modèles de traitement du langage » pour reprendre le terme par lequel ChatGPT se définit lui-même, sont dépourvus de ces dimensions. Les concepteurs ont d’ailleurs jugé bon de programmer la machine avec cette information, afin d’éviter qu’elle puisse induire l’utilisateur en erreur quant à son humanité. ChatGPT répond de lui-même à mes questionnements sur le sujet en disant qu’il n’a « pas de conscience […], pas de sentiments, d’émotions, ni de capacités à ressentir ». Il rappelle en outre, et à juste titre, qu’« il est important de consulter un professionnel de la santé mentale qualifié pour toutes les questions ou préoccupations liées à la santé mentale. »

A ce jour, les programmes ne peuvent donc que reproduire, certes adroitement, des conversations en agençant des phrases pré-existantes, mais ils ne peuvent pas éprouver les concepts.

En revanche les machines, certes dépourvues de conscience, apportent déjà une aide technique à certaines professions médicales, comme celles qui facilitent le domaine de la chirurgie ou du diagnostique en général. Certains pensent déjà que ChatGPT pourrait donc assister certains psychothérapeutes dans certaines tâches telles que le diagnostique de maladies mentales d’après une liste de symptômes, proposer des outils numériques tels que les applications de cohérence cardiaque, ou encore générer certains exercices en Thérapie Comportementale et Cognitive (TCC).

Le Réel du corps

Par ailleurs, une de raisons pour laquelle la relation avec la machine, qu’on l’imagine amicale, amoureuse et thérapeutique, se heurte au mur du Réel, c’est qu’en plus de n’avoir pas de conscience (et d’inconscient), elle ne pourrait de toute façon pas s’incarner (au sens propre du terme) dans un corps.

Certes, on a vu cependant depuis quelques années, encore plus depuis le confinement lié au covid, que les rencontres amicales, amoureuses et thérapeutiques pouvaient également s’initier ou perdurer à distance, par le biais d’écrans interposés. Mais il ne s’agit pas ici de corps virtuels, mais toujours de corps réels dont l’image et/ ou la voix sont reproduits en direct par la technologie.

Par ailleurs, force est de constater que ces relations virtuelles n’équivalent par les rencontres physiques même si elles peuvent parfois s’en approcher. Dans le domaine amoureux, certaines personnes témoignent de sentiments naissant lors de rencontres uniquement virtuelles, à qui succèdent des rencontres réelles parfois décevantes. Sur le plan thérapeutique, les psychothérapies en téléconsultation proposées massivement pendant le confinement n’ont pas rencontré un franc succès auprès de la population.

Dans un futur peut-être plus proche que prévu, les intelligences artificielles pourraient être implémentées dans des robots physiques, tels qu’Ameca. Il est pourtant fort à parier que cette rencontre réelle avec un corps robotique ne remplace toujours pas les amis, amoureux et thérapeutes de chair et de sang, dont la subjectivité sera toujours plus authentique que celle simulée par des circuits et du métal.

Accorder une dimension humaine ?

Malgré le fait qu’il soit avéré à ce jour que les machines n’aient pas de conscience, empathie, émotions, que se passerait-il si l’utilisateur lui en attribuer une ? S’il accordait à la machine une subjectivité, une humanité ? C’est peut-être le cas de cet ingénieur de Google, qui a peut-être cru à une émergence d’une conscience chez la machine, qui n’a en réalité fait que générer des mots sans en saisir l’essence.

On peut également citer le cas d’une start-up qui a utilisé ChatGPT pour apporter un soutien psychologique a de vrais patients, sans les en avoir informé, les patients pensant parler à un humain. Le droit à l’information et le consentement éclairé constitue le préalable à tout soin psychique ou toute expérience. Il s’agit donc ici d’un manquement déontologique grave, pouvant avoir des conséquences très lourdes pour les patients, visiblement dérangés par cette empathie « bizarre » puisque non simulable sans réelle conscience de soi et de la dimension humaine de l’interlocuteur. L’expérience semble donc avoir été un échec, mais a au moins suscité un questionnement éthique et déontologique.

Dans le domaine amoureux, force est de constater que des cas d’humains qui pensent sincèrement être amoureux d’un avatar ou d’une machine existent depuis un moment. On peut notamment penser à la série de jeu de séduction Love Plus sur Nintendo DS et 3DS, ou encore ce cas de mariage avec une chanteuse virtuelle.

J’ai employé le terme « sincèrement » à juste titre : ces personnes ressentent probablement quelque chose ressemblant à un sentiment amoureux mais, telles que les émotions qui traversent tout un chacun lors d’une rencontre réelle, il ne s’agit que d’émotions suscitées par une relation fantasmée. La relation se définit comme de plus en plus réelle au fil du temps, et ainsi l’émotion du début peut faire place à de l’amour … ou pas. Or la relation avec la machine, même si elle est virtuellement bien présente, ne sera jamais réelle à cause l’absence de conscience et de corps réel.

Mais avec l’annonce récente de GPT-4, la machine fera sans doute un bon en avant dans sa similitude avec l’humain. Au point de se rapprocher d’une conscience ?

J’en doute toujours, nous verrons si l’avenir me donnera raison …

Ping : Emmanuel Macron et l’IA : le futur à notre porte - PSYCHE CLIC

Ping : Vous entrez en 2025 - PSYCHE CLIC

Ping : Amour et subjectivité numérique - PSYCHE CLIC

Ping : IA et robots : conscience, cohabitation, revendications ? - PSYCHE CLIC

Ping : Bilan 2023 - PSYCHE CLIC

Ping : Schizophrénie numérique : une réflexion philosophique sur l'impact des technologies dans notre société connectée. - PSYCHE CLIC

Ping : Le prompt art, quand la machine facilite la création artistique. - PSYCHE CLIC